[!NOTE] 本稿は査読前のプレプリント(arXiv: 2512.06711)に基づいています。

これは何の話?

個人情報を含むデータでLLMを微調整する際に、プライバシーを数学的に保証しながら精度を維持する手法の研究です。本論文は、差分プライバシー(個々のデータポイントの影響を制限する技術)とパラメータ効率的な微調整(PEFT)を統合した新しいフレームワークを提案しています。

対象読者は、医療・金融・人事など機密データを扱う企業のMLエンジニアや、プライバシー規制対応を検討するAI担当者です。

何がわかったか

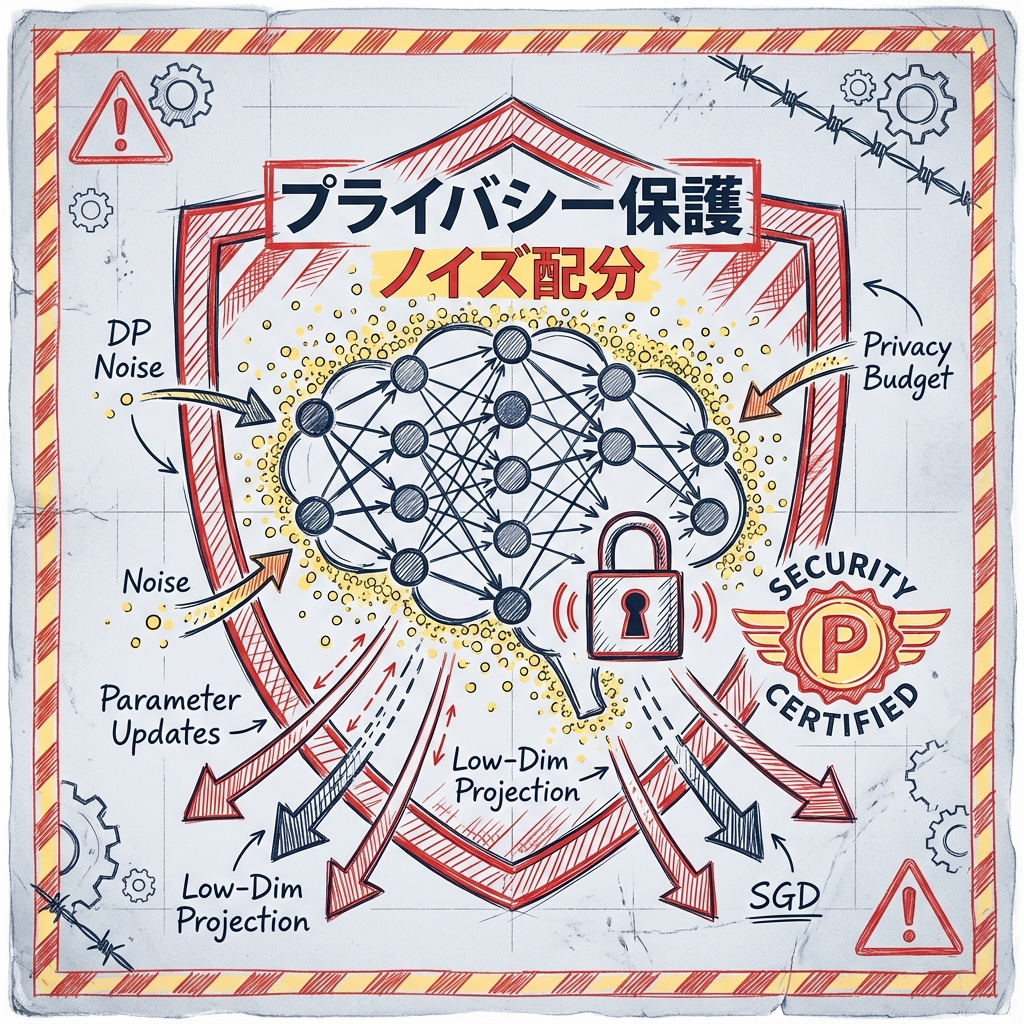

提案手法では、LLMのバックボーン(本体部分)を固定し、低次元の射影空間でのみパラメータを更新します。勾配計算時にクリッピング(勾配の大きさ制限)と適応的なノイズ配分を導入することで、プライバシー予算の消費を抑えつつ学習の安定性を確保しています。

実験では、ハイパーパラメータ感度、環境変化、データ感度の3つの観点で評価を行い、ベースラインモデルと比較して精度・プライバシー予算・パラメータ効率のすべてで優位性を示しました。特に、多様で不確実なデータ条件下でも安定した性能を維持することが確認されています。

他とどう違うのか

従来の差分プライバシー適用では、ノイズ追加による精度低下が大きな課題でした。本手法は、PEFT(LoRAなど)の低次元更新と差分プライバシーのノイズ配分を協調設計することで、この問題を軽減しています。

また、マルチタスク指示シナリオでの性能変動やプライバシーリスクを明示的に対処している点も、先行研究との差異です。

なぜこれが重要か

GDPRやHIPAAなどの規制下では、個人データを用いたAI学習にプライバシー保護が求められます。差分プライバシーは数学的なプライバシー保証を提供しますが、従来は精度との大きなトレードオフがありました。

本手法により、企業は規制準拠とモデル性能のバランスを取りやすくなり、機密データを活用したLLMカスタマイズの実現可能性が高まります。

未来の展開・戦略性

プライバシー保護型のLLM微調整は、医療診断支援、金融リスク評価、HRテック(採用・評価AI)など、機密情報を扱う分野での需要が高まると予想されます。

今後は、より大規模なモデル(Llama 3、GPT-4クラス)への適用検証や、連合学習(Federated Learning)との組み合わせによる分散プライバシー保護の研究が進む可能性があります。

どう考え、どう動くか

例えば、医療データでLLMをカスタマイズしたい病院IT部門は、まず本手法の勾配クリッピング設定を小規模データで試し、プライバシー予算(ε値)と精度のトレードオフを自組織の要件と照合することが考えられます。

- 自社のプライバシー要件(規制、社内ポリシー)を明確化し、許容できるε値を設定する。

- LoRAやAdapterなど既存PEFTライブラリとの互換性を確認し、実装コストを見積もる。

- 差分プライバシーの監査ツール(例:OpenDP)を用いて、実際のプライバシー消費をモニタリングする。

次の一歩:

- 今日やること:差分プライバシーの基本概念(ε、δ、感度)を復習し、本論文のノイズ配分メカニズムを理解する。

- 今週やること:PEFTライブラリ(PEFT by Hugging Face)のコードを確認し、差分プライバシー統合の実装難易度を把握する。

限界と未確定

- 実験で使用したモデルサイズと具体的なデータセットが論文要旨からは明確でない。詳細は論文本文の確認が必要。

- 実運用環境での計算オーバーヘッド(学習時間増加率など)が定量的に示されていない。再現実験で計測が必要。

- マルチタスク設定の具体的なタスク数や種類の詳細は、補足資料の確認が次のステップ。

用語ミニ解説

- 個々のデータポイントの影響を数学的に制限し、プライバシーを保証する技術です。(差分プライバシー / Differential Privacy)

- モデル全体ではなく一部のパラメータのみを更新する効率的な微調整手法です。(パラメータ効率微調整 / Parameter-Efficient Fine-Tuning)

出典と日付

arXiv(公開日:2025-12-13):https://arxiv.org/abs/2512.06711