記事論文

arXiv••2 min read

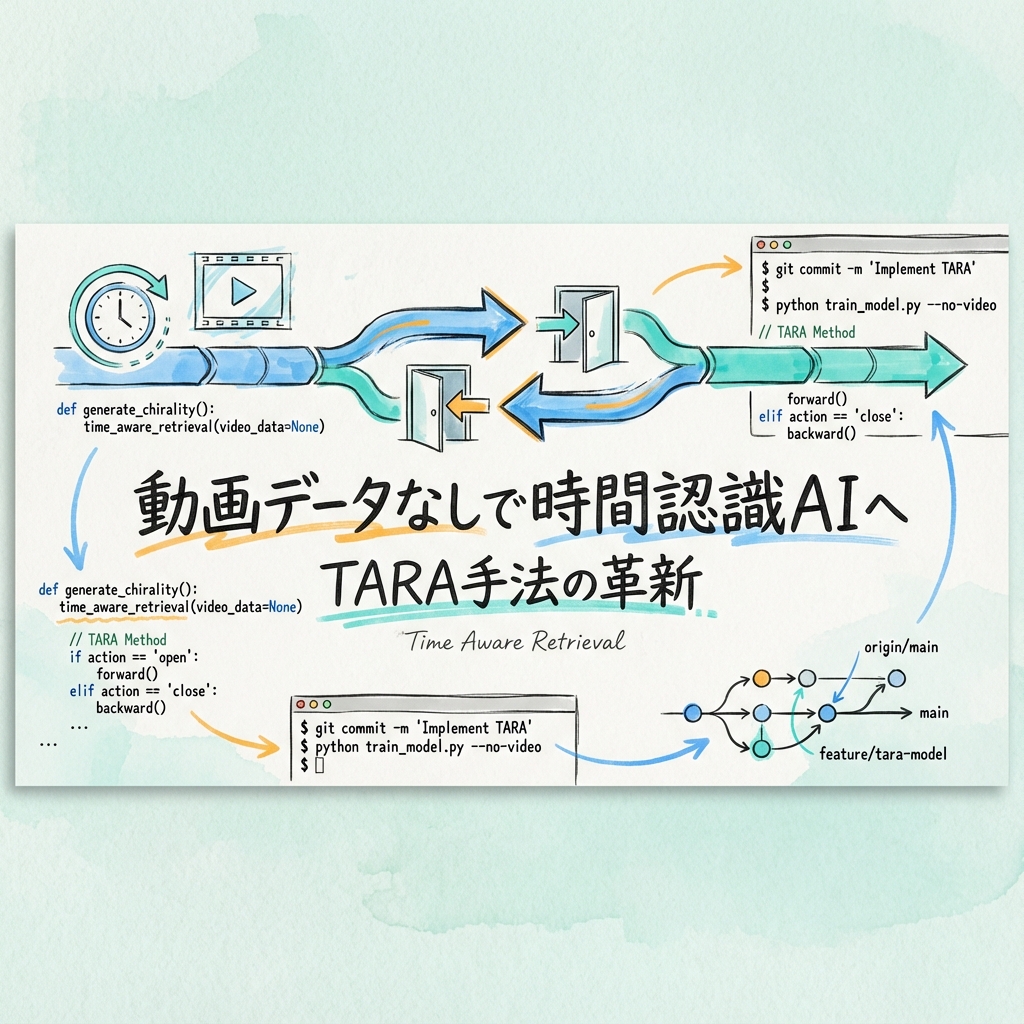

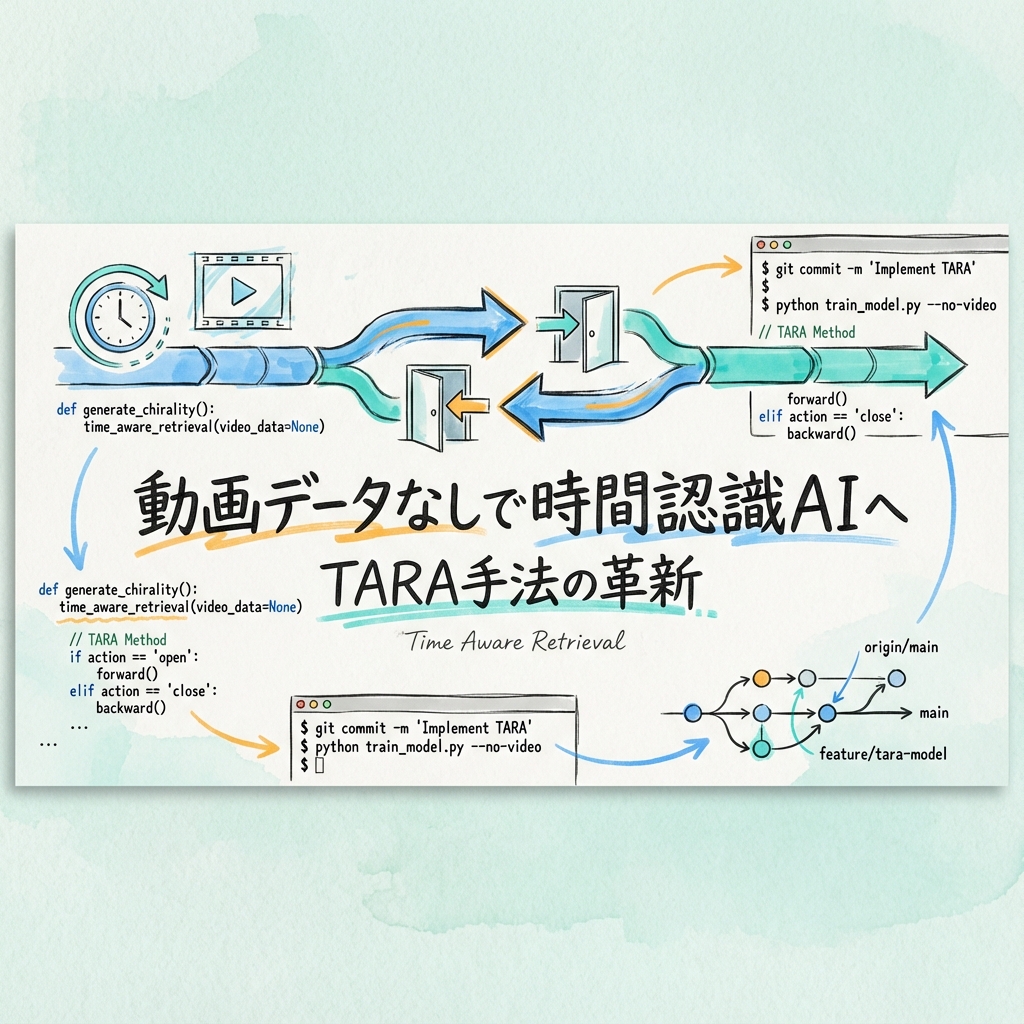

TARA:動画データなしでマルチモーダルLLMを時間認識型埋め込みモデルに変換する手法

マルチモーダルLLMを動画データなしで時間認識型埋め込みモデルに変換する手法「TARA」。時間的に反対の動作を識別するベンチマークを提案し、否定表現・動詞・副詞理解でもSoTAを達成。

#動画理解#マルチモーダル#検索

Research / 2 件

マルチモーダルLLMを動画データなしで時間認識型埋め込みモデルに変換する手法「TARA」。時間的に反対の動作を識別するベンチマークを提案し、否定表現・動詞・副詞理解でもSoTAを達成。

マルチモーダルLLM(MLLM)が同じ意味情報を持つ画像・テキスト・混合入力に対して一貫した回答を返せない問題を、REST/REST+ベンチマークで15モデル横断検証。OCR精度とは独立した不整合が存在し、安全性・信頼性に課題を示唆。