[!NOTE] 本稿は査読前のプレプリント(arXiv)に基づいています。

1. これは何の話?

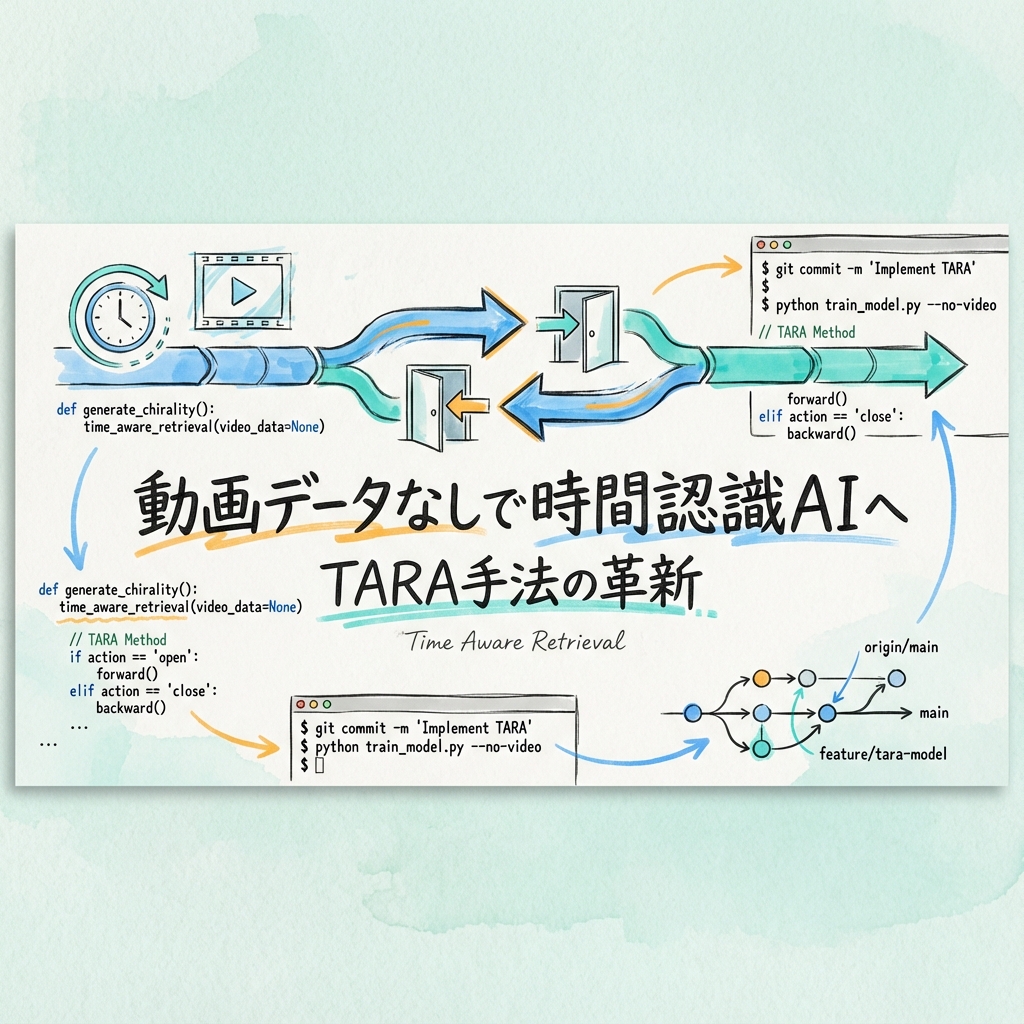

動画理解AIの開発者・研究者向けに、マルチモーダルLLM(MLLM)を動画データなしで時間認識型の動画-テキスト埋め込みモデルに変換する手法「TARA(Time Aware Retrieval Adaptation)」を提案した研究です。

従来の動画-テキスト検索モデルは時間的な順序関係の理解が弱く、「ドアを開ける」と「ドアを閉める」のような時間的に反対の動作を区別できない課題がありました。

2. 何がわかったか

TARAの主な成果は以下のとおりです:

- 動画データ不要:MLLMから動画-テキスト埋め込みモデルへの変換に動画データを使わないシンプルで効率的なレシピ

- 時間認識ベンチマーク:時間的に反対の動作(キラル動作)をハードネガティブとして使用する新評価基準を提案

- 多面的な効果:否定表現認識(NegBench)、動詞・副詞理解でも最先端性能を達成

TARAは標準ベンチマークでも強力な結果を示しつつ、キラルベンチマークで既存モデルを大幅に上回りました。

3. 他とどう違うのか

従来の動画-テキストモデルは大量の動画データで学習する必要がありました。TARAは動画データなしでMLLMを適応させることで、データ収集・アノテーションコストを大幅に削減しています。

また、単に「時間を理解する」だけでなく、否定表現(「~していない」)や動詞・副詞のニュアンス理解も向上する副次的効果が確認されました。

4. なぜこれが重要か

動画検索は監視映像分析、コンテンツ推薦、アクセシビリティなど多くの応用があります。時間的順序を正しく理解することで、「転倒した」と「立ち上がった」を区別するような安全性に関わる検索精度が向上します。

5. 未来の展開・戦略性

TARAのアプローチは「大規模動画データセットがなくても高度な動画理解が可能」という方向性を示しており、リソースが限られた組織でも動画AIの開発に参入しやすくなります。MLLMをベースにした多目的な動画理解システムの構築が加速する可能性があります。

6. どう考え、どう動くか

動画検索や動画分析システムを開発中のチームは、TARAのアプローチを参考に自社モデルの時間認識能力を評価・改善する機会があります。

指針:

- 自社の動画検索システムで時間的に反対の動作を正しく区別できるか検証する。

- 動画データなしでMLLMを適応させる手法の実装可能性を検討する。

- キラルベンチマークの概念を自社評価基準に取り入れる。

次の一歩:

- 今日やること:arXivで本論文を読み、TARAの適応手法を理解する。

- 今週やること:自社の動画検索システムで時間認識の課題を洗い出す。

7. 限界と未確定

- 「動画データなし」の詳細な条件(画像データは使用しているか等)は論文本文の確認が必要。

- 長時間動画や複雑なシナリオでのスケーラビリティは未検証。

- プレプリント段階であり、再現性の検証が待たれる。

8. 用語ミニ解説

- 鏡像関係にある動作、つまり時間的に反対の動作。「開ける↔閉める」「上がる↔下がる」など。(キラル動作 / chiral actions)

9. 出典と日付

arXiv(公開日:2025-12-12):https://arxiv.org/abs/2512.13511